Implémentation Hadoop DataLake "Configuration HDP"

Nous allons dans cet article accéder à la ligne de commande de la Sandbox HDP, à l'interface utilisateur Web Ambari, à Hive & Ranger pour créer un utilisateur pour notre configuration d'implémentation.

Une fois que la sandbox et/ou le cluster HDP est opérationnel, utilisez n’importe quel outil client SSH préféré pour vous connecter à la machine HDP (sandbox-hdp.hortonworks.com) avec l’utilisateur root et le mot de passe hadoop. Lors de la première connexion, il peut vous demander de réinitialiser le mot de passe root. Une fois que vous êtes en mesure de vous connecter au nœud HDP, suivez les étapes suivantes.

Dans notre labs, le HDP 2.6.4 Sandbox s’exécute sur VMWare avec une adresse IP 192.168.126.128 et un accès ssh sur le port 2222. Changez donc votre adresse IP en conséquence dans le reste de la configuration du labs. Pour en savoir plus sur les détails de la pile du sandbox, consultez le fichier sous /opt/sandbox.info (par exemple, version du système d’exploitation : CentOS version 6.9).

Remarque :

Hôte Sandbox: ssh root@192.168.126.128 -p22

HDP Sandbox: ssh root@192.168.126.128 -p2222

Avant de poursuivre, ajoutons une entrée d’alias d’hôte dans le fichier hosts, sous Windows C:\Windows \System32\drivers\etc\hosts

192.168.126.128 sandbox-hdp.hortonworks.com

Premièrement, créons un utilisateur unix nommé edw_user avec le groupe hdfs, suivi du répertoire de base de l’utilisateur dans HDFS. Définissez le mot de passe de edw_user sur hadoop.

Ambari Sandbox

Se connecter à Ambari Web Admin Console http://192.168.126.128:8080 avec l'utilisateur admin et le mot de passe admin. Si vous ne parvenez pas à vous connecter, vous devrez peut-être réinitialiser le mot de passe de connexion de l'administrateur. Si tel est le cas, utilisez depuis la console de ligne de commande shell ambari-admin-password-reset, puis réinitialisez le mot de passe en conséquence. Commencez par vérifier que tous les composants de chacun des services, à savoir HDFS, YARN, MapReduce2, Hive, Oozie, Zookeeper, Flume et Ranger sont opérationnels. Sinon, démarrez tous les composants et services pertinents.

Ensuite, sous « Ambari Views », cliquez sur le lien « Files View » et vérifiez que le dossier « edw_user » et les autorisations figurant dans le répertoire « user » sont corrects

Ensuite, allez dans admin puis « Manage Ambari ». Sous Gestion des « User + Group Management », cliquez sur « Users ». Cliquez ensuite sur « Create Local User ». Entrez les informations d'identification de l'utilisateur et enregistrez :

Cliquez ensuite sur « Roles » sous Sandbox. Ajoutez edw_user sous l’opérateur de « Service Operator ». Cliquez ensuite sur « Views ». Accédez à la vue du gestionnaire de flux de travail. Sous Autorisations de cluster locales, accordez l’utilisation de l’autorisation au rôle d’opérateur de service. Une fois terminé, redémarrez le serveur Ambari.

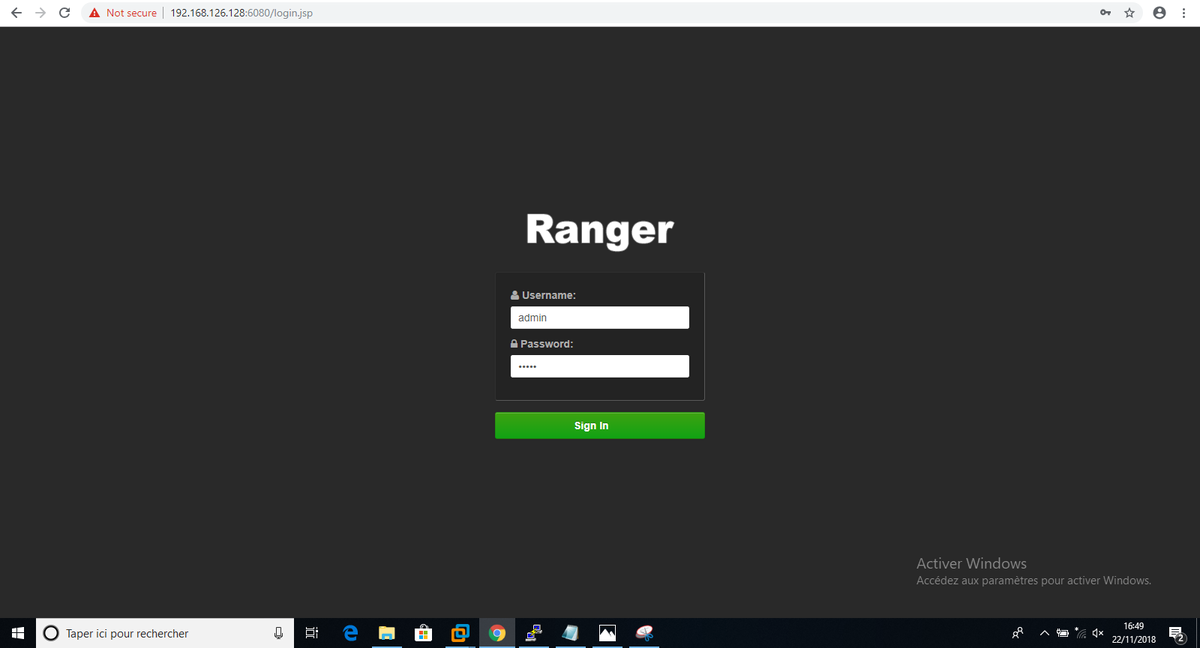

Ranger

Cliquez ensuite sur Service Ranger, accédez à l'interface utilisateur d'administration de Ranger http://192.168.126.128:6080. Connectez-vous à Ranger avec nom d'utilisateur « admin » & mot de passe « admin ». Sous « Settings » -> « Users/Groups », vérifiez que edw_user User & Group a été créé automatiquement.

Ensuite, allez à « Access Manager » -> « Resource Based Policies ». Cliquez ensuite sur « Sandbox_hive Policies ». Cliquez sur « Add New Policy » pour créer une nouvelle stratégie Hive, comme indiqué sur les captures :

/image%2F1934921%2F20171024%2Fob_d9d788_blog.jpg)

/image%2F1934921%2F20200112%2Fob_ffa881_1.jpg)

/image%2F1934921%2F20191217%2Fob_4fdf81_blogpic1.png)

/image%2F1934921%2F20190129%2Fob_30dfff_qliklogo.jpg)

/image%2F1934921%2F20190123%2Fob_aa4566_oozie.jpg)

/image%2F1934921%2F20170717%2Fob_b1c54c_big-data.jpg)